Nieuwe technologie? Nieuwe risico’s!

De snel toenemende populariteit van ChatGPT en andere AI-toepassingen leidt tot allerlei nieuwe risico’s. Wat kunnen bestuurders doen om die te beperken? Francois Candelon van adviesbureau BCG pleit voor een gedifferentieerde aanpak.

Opeens kan iedereen computers pijlsnel gedetailleerde teksten en beelden laten genereren door eenvoudige, in huis-tuin-en-keukentaal gestelde invoerprompts in te voeren. De introductie van Open AI’s ChatGPT eind november was maar het begin. Nu heeft Microsoft een nieuwe versie van Bing gelanceerd die wordt aangedreven door kunstmatige intelligentiesoftware van OpenAI. Waarschijnlijk komt Google heeft binnenkort met een eigen chatbotproduct, Bard. Talloze andere bedrijven kwakken hun eigen kunstmatig intelligente apps op de markt, van Jasper (een ’tool’ om snel marketingteksten te genereren) tot Github Copilot (die code genereert, zodat waarmee programmeurs hun werkzaamheden makkelijker kunnen uitvoeren, en productiviteitswinsten van tientallen procenten kunnen boeken).

Uiteraard biedt deze plotselinge opkomst van ‘generatieve’ kunstmatige intelligentie bedrijven allerlei kansen. Adviesbureau BCG (van de bekende matrix) gelooft zelfs dat de digitale transformatie van bedrijven vleugels kan krijgen, en heeft in september een eigen ‘unit’, BCG X opgericht met ongeveer 2.500 technologen, designers en digitale consultants – kortom mensen die bedrijven kunnen adviseren hoe ze gebruik kunnen maken van de mogelijkheden die AI biedt.

Masterclass: kansen en risico’s generatieve AI

Tijdens een ‘masterclass’ van BCG kwamen die kansen aan de orde. Duidelijk werd dat elk bedrijf wel wat met AI kan. Of het nu gaat om predictive maintenance (op grond van data voorspellen wanneer onderhoud aan apparatuur moet plaatsvinden), voorspellingen genereren of consumenten nieuwe producten aanbevelen met een ‘recommendation engine’, de helpdeskmedewerker z’n werk beter laten doen door een chatbot uit te rusten met kunstmatige intelligentie of om een toepassing als ChatGPT of Jasper.AI om de marketeer op creatieve ideeën te brengen en z’n teksten sneller te laten schrijven: de toepassingen van kunstmatige intelligente zijn onbeperkt.

Alleen zullen lang niet alle bedrijven volledig op eigen kracht toepassingen kunnen ontwikkelen, aangezien dat tientallen miljoenen kost. De meeste bedrijven zullen het dus moeten doen met wat ze krijgen aangericht met wat ze ‘out of the box’ krijgen aangereikt door OpenAI of andere aanbieders, en dat al dan niet een beetje ’tweaken’: de kant-en-klare algoritmen met eigen data trainen, bijvoorbeeld, of een eigen schil om ChatGPT of een andere applicatie heen bouwen.

Schaduw-AI en ‘capacity overhang’

Voor elk wat wils, was kortom de strekking van de masterclass. Tegelijkertijd werd ook benadrukt dat bestuurders ook rekening moeten houden met de risico’s die de nieuwe technologie oplevert. Die risico’s zijn aanzienlijk. In de eerste plaats omdat zoveel mensen kunnen omgaan met de nieuwe generatie AI-toepassingen.

Dit leidt tot een opkomst van ‘schaduw-AI’: het gebruik van ChatGPT en andere AI-toepassingen zonder dat hiervoor in de organisatie toestemming is gegeven. Sterker nog, misschien zelfs zonder dat de organisatie er van op de hoogte is. Met alle gevaren van dien. Denk aan het risico dat werknemers onnauwkeurige, bevooroordeelde en mogelijk schadelijke beslissingen nemen (want betrouwbaar zijn de AI-toepassingen lang niet altijd). Of denk aan de risico’s op het gebied van privacy en beveiliging van gegevens.

Deze risico’s worden nog eens vergroot doordat bedrijven maar al te vaak een soort paard van Troje in huis halen wanneer ze met AI-toepassingen gaan werken. ‘Capacity overhang’ heet dat: de AI-modellen van OpenAI andere ‘Large Language Models’ zijn zo groot en complex – en de beschikbare technieken om ze te evalueren nog zo onvolwassen – dat het moeilijk is om de risico’s die ze opleveren volledig te begrijpen.

Gedifferentieerd risicobeleid

Het is uiteindelijk de taak van het bestuur in een bedrijf om die bedreigingen het hoofd te bieden (net zo goed als het bestuur een strategie moet formuleren om in te spelen op de kansen). “Daarvoor hoeft een bestuurder niet volledig ingevoerd te zijn in technische ins en outs van AI. Wel moet hij enige basis kennis hebben van wat AI allemaal vermag”, zei Francois Candelon, managing director en senior partner van BCG.

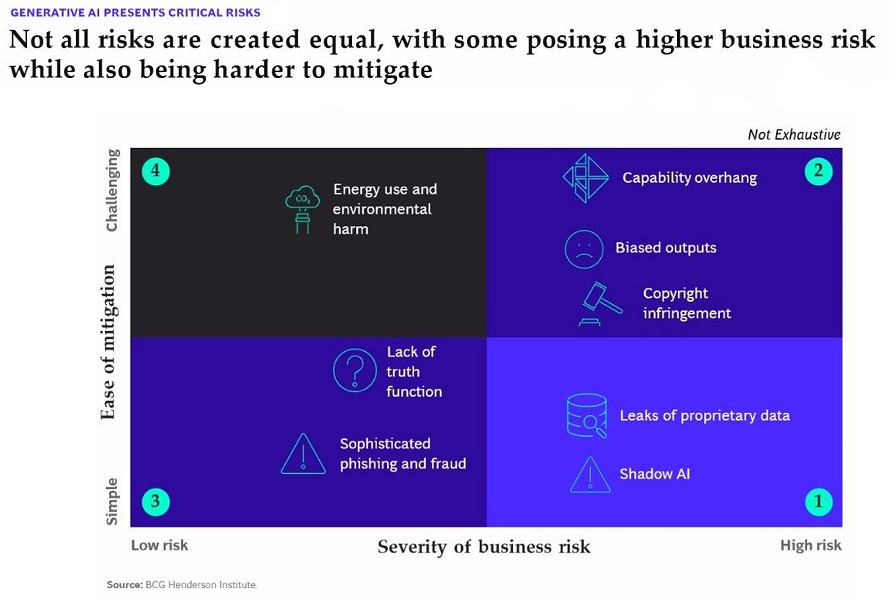

Daarnaast moeten bestuurders volgens hem een gedifferentieerd riscobeleid voeren. Dat wil zeggen: met maatregelen die overeenstemmen met de aard en omvang van het precieze risico. Dus niet met hagel schieten, maar kijken welke risico’s de onderneming loopt, hier prioriteit in aanbrengen en passende maatregelen nemen. Candelon pakte er maar weer eens een matrix bij – ‘daar houden we tenslotte van bij BCG’ – met een x-as die weergeeft hoe ernstig een bepaald gevaar is en een y-as die weer geeft hoe makkelijker er tegen kan worden opgetreden. (Zie illustratie). Even ‘plotten’ en je weet in grote lijnen wat dit betekent voor je risicomanagement.

Het belangrijkste advies: doe vooral wat om datalekken te voorkomen (zoals sinds de invoering van de AVG ook al het devies is) en probeer greep te krijgen op alle schaduw-AI in het bedrijf. Dat is niet al te lastig, en je pakt er grote gevaren mee aan. Volgens BCG, tenminste.

In werkelijkheid zal het niet altijd meevallen om de schaduw-AI uit te bannen, gezien de populariteit van ChatGPT en het verslavende karakter van veel van de nieuwe AI-toepassingen. Want wie vindt het niet heerlijk om in enkele seconden een zelfportret in de stijl van Vincent van Gogh te maken of een socratisch gesprek te voeren met een ‘avatar’ van de filosoof zelf? Of om ChatGPT even wat titels te laten verzinnen voor een kop boven een artikel als dit?